Ce texte a été publié dans le n°23 des Cahiers antispécistes (2003).

193 min.

Résumé: L'émergence de l'animalisme, et donc de la prise au sérieux de la sentience des animaux non humains, rend intenable la division traditionnelle du monde entre nature et humanité. La sentience, autrefois vue comme l'apanage de l'espèce humaine, fait en réalité partie du monde physique; la science doit en rendre compte. Le présent article vise à énoncer quelques contraintes à laquelle devra répondre une physique sentientiste.

Ce problème – dit «problème difficile de la conscience» (hard problem of consciousness) selon l'expression de David Chalmers (1995) – a fait l'objet de nombreuse tentatives de résolution, ou encore de négation. Leur défaut commun est de n'envisager la question que sous un angle descriptif, à l'exclusion de toute considération éthique.

Or non seulement l'existence, objective, de la sentience (du «subjectif») fait intervenir de manière essentielle l'éthique, mais il en va de même de l'existence de ce qu'on appelle «monde matériel». L'éthique doit être définie, par souci de cohérence et de complétude, comme la théorie du prescriptif en général, c'est-à-dire de la réponse juste à la question «Que faire?»; elle inclut en particulier la prudence (souci de ses propres intérêts futurs). Loin d'être une particularité humaine, elle est le fait de tout être sentient, délibératif, puisqu'il doit répondre à cette question; les animaux non humains sont, comme les humains, des agents moraux.

On dit souvent que les prescriptions, contrairement aux descriptions, n'ont pas de valeur de vérité (ne sont ni vraies ni fausses). Cependant, l'examen des fondements généraux de notre connaissance fait apparaître qu'à défaut de fondements rigoureux, nous avons seulement une impossibilité de ne pas croire en l'existence du monde matériel; et que cette même impossibilité concerne l'existence des vérités prescriptives. Si la réalité du prescriptif est mal fondée, elle ne l'est pas plus que notre croyance en l'existence même du monde. De plus, ces deux impossibilités se renvoient l'une à l'autre.

La vision du monde que nous donne la physique actuelle rend son évolution équivalente à l'exécution d'un algorithme. Or l'exécution d'un algorithme n'a de réalité que conventionnelle et n'est donc pas susceptible de produire de la sentience (des qualia). Adoptant la distinction faite par Roger Penrose entre déterminisme calculable (par un algorithme) et déterminisme en général (potentiellement non calculable), et sur la base de l'impossibilité de ne pas croire en l'objectivité de la valeur de vérité des propositions prescriptives, je conclus comme Penrose que le monde physique ne peut être régi par un déterminisme calculable. La sentience apparaît comme un phénomène physique, potentiellement déterministe, mais non calculable, régi par des lois encore inconnues.

Je conclus en esquissant des critères pour la reconnaissance de la présence de la sentience dans un organisme donné.

La sensibilité*, objet central de toute éthique et de toute action, est une réalité du monde. Elle est une réalité en soi, dont l'existence ne dépend pas d'un point de vue; elle en est une réalité objective. Dans la mesure où notre cerveau est fait de matière – dans la même mesure que le sont une table ou un caillou – la sensibilité est une propriété possible de toute matière. Elle est du domaine de la physique, laquelle doit rendre compte des relations qu'elle a avec les autres éléments du monde réel, et permettre de déterminer quand, où et avec quelles caractéristiques (souffrance, plaisir et autres qualia1) elle se produit.

Pourtant, la physique d'aujourd'hui est incapable d'intégrer la sensibilité dans sa description du monde. Le problème ne se résoudrait pas par la simple découverte d'un nouveau phénomène ou d'une nouvelle loi. Nous avons besoin d'une refonte en profondeur de notre conception de la réalité et de la physique. Je n'apporterai pas ici les clés d'une telle refonte, mais me contenterai d'expliciter quelques raisons qui me la font croire nécessaire, et de proposer quelques conditions qu'elle devra satisfaire.

Mes réflexions s'inspirent pour une part importante des travaux que le mathématicien anglais Roger Penrose a exposés dans deux ouvrages disponibles en français2, dans lesquels il soutient que notre physique actuelle est incapable de rendre compte des processus mentaux. Il le fait sur la base de nos facultés de compréhension mathématique et de l'impossibilité de simuler celles-ci par l'exécution d'un algorithme; cette impossibilité découlant, selon lui, d'une application du célèbre théorème d'incomplétude de Gödel (1931). Je crois cette argumentation très importante, mais non tout à fait concluante. En filigrane dans les ouvrages de Penrose se trouve ce qui constitue mon argumentation centrale: le caractère incontournable du point de vue interne, subjectif, et le fait que ce point de vue rend impossible de se faire une théorie du monde sans attribuer au subjectif, c'est-à-dire à la sensibilité, et aussi à la vérité des propositions prescriptives et à la liberté de choix, le caractère de faits. C'est aussi sur cette base, je crois, que l'on peut confirmer la justesse des déductions de Penrose, et en particulier de son affirmation selon laquelle l'évolution du monde ne peut être entièrement soumise à un déterminisme calculable; si le monde est déterministe, il doit l'être au moins en partie d'une manière non calculable, c'est-à-dire non algorithmiquement reproductible.

Penrose s'intéresse à la pensée sous une de ses formes les plus «abstraites», et spécifiquement humaines, le raisonnement mathématique. Ce que suggèrent cependant ses travaux est bien que toute compréhension réelle – même les raisonnements les plus pratiques, présents assurément chez bien des animaux non humains – consiste nécessairement en un processus non algorithmique. La compréhension réelle implique la perception du caractère de vérité de certains faits, qu'il s'agisse de la présence d'un prédateur dans les environs ou d'un résultat mathématique; elle ne peut se ramener à l'exécution – nécessairement insensible – d'un algorithme. Je soutiendrai que la sensibilité, l'intelligence (faculté de comprendre), la liberté et l'éthique (recherche non algorithmique de la réponse vraie à la question «Que faire?») sont intimement liées, et que par conséquent tant l'intelligence que la liberté et l'éthique sont des caractéristiques de tout être sensible.

Cela permettra déjà de dégager, ou plutôt de commencer à mieux fonder, un certain nombre de critères qu'il nous paraît naturel d'adopter pour déterminer si un être donné est sensible; comme le caractère non «automatique» de son comportement ou la possession de tissus d'un certain type, à savoir les tissus nerveux. Cela permettra de comprendre la place de la sensibilité dans l'évolution. Cela permettra de fonder, comme vraies, nos obligations morales envers tout être sensible quel qu'il soit. Enfin, cela impliquera la nécessité de reconstruire nos conceptions de la réalité physique et permettra d'esquisser quelques contraintes que ces nouvelles conceptions devront satisfaire.

1. Certitudes des uns, certitudes des autres

On pourra s'étonner que j'affirme ici l'incapacité de notre physique à rendre compte de la sensibilité. De fait, ce n'est pas là la position de bon nombre de philosophes, et tout particulièrement de philosophes antispécistes. Peter Singer, par exemple, consacre huit pages dans La Libération animale3 à contrer la thèse cartésienne selon laquelle les animaux ne posséderaient aucune sensibilité, ne ressentiraient rien du tout. Il le fait sur la base d'une série d'arguments à caractère scientifique, sans se poser la question du statut scientifique de la sensibilité elle-même. Ses arguments concernent le comportement des animaux, leur possession d'un système nerveux, et l'utilité évolutionnaire de la douleur; c'est sur cette base qu'il conclut a contrario à l'absence de sensibilité chez les plantes4. On voit fréquemment mentionnée aussi la présence chez tel ou tel animal de certaines substances chimiques, telles les endorphines mentionnées par Joan Dunayer dans son article sur les poissons paru dans le numéro 1 des Cahiers antispécistes5. Mon expérience est que de façon très générale les militants antispécistes tendent à penser que le statut scientifique de la douleur et de la sensibilité pose peu de problèmes, et que notre incapacité, par exemple, à dire si une fourmi peut ou non souffrir résulte simplement de l'absence d'attention accordée par les scientifiques à la question.

Cette attitude contraste fortement avec une autre, très répandue, justement, chez les personnes de culture scientifique et qui se réclament d'un certain rationalisme. Chez elles, la tendance est au contraire de déclarer que la question de savoir si un animal donné est ou non sensible est dépourvue de sens. Erwin Schrödinger, un des fondateurs de la mécanique quantique, a formulé avec netteté cette position – qui n'était pas la sienne – dans la réponse imaginaire, mais typique d'un certain point de vue, qu'il met dans la bouche d'un «rationaliste» à qui on demanderait «quel type de processus matériel est directement associé à la conscience»6:

Un rationaliste peut être tenté de régler cette question brutalement, à peu près comme suit. D'après notre propre expérience, et par analogie lorsqu'il s'agit des animaux les plus évolués, la conscience est connectée à certains types d'événements dans de la matière organisée et vivante, c'est-à-dire à certaines fonctions nerveuses. Se demander jusqu'où, en descendant l'échelle des espèces animales, il y a encore quelque forme de conscience, se demander à quoi peut ressembler la conscience dans ses étapes précoces, relève de la spéculation gratuite; ce sont des questions auxquelles on ne peut pas apporter de réponse et qui doivent être laissées à des rêveurs désœuvrés. Il est encore plus vain de se perdre en pensées sur la possibilité que d'autres événements, des événements dans la matière inerte, sans même parler de tous les événements matériels, sont peut-être aussi, d'une façon ou d'une autre, associés à la conscience. Tout cela est fantaisie, aussi irréfutable qu'indémontrable, et n'est donc d'aucune utilité pour la connaissance.

Cette position qui se veut «rationaliste»7 déclare, comme je l'ai dit, dépourvue de sens la question de la sensibilité (conscience) animale. Elle admet par contre sans réserves «notre» sensibilité – «notre» voulant dire celle des êtres humains. Celle-ci résulterait de notre expérience, et serait donc de l'ordre des faits, ferait partie de la réalité du monde; elle serait d'ailleurs de quelque façon reliée aux «fonctions nerveuses», c'est-à-dire à des événements physiques banals, observables. Mais en dehors de l'espèce humaine – et de quelques animaux, ceux qui sont «les plus évolués» – le statut de la sensibilité change radicalement. Concernant les animaux «peu évolués», et les objets inanimés, cette position n'affirme pas leur absence de sensibilité; elle dit, plutôt, que dans leur cas la question de la sensibilité n'a pas de sens. Elle ne serait pas, dans leur cas, de l'ordre du fait.

Les attitudes des uns et des autres ont en commun de considérer la question du statut scientifique de la sensibilité animale comme un non-problème: les uns, parce qu'ils la supposent résolue, les autres parce qu'ils l'estiment dépourvue de sens. Je crois bon de briser ces deux certitudes tranquilles; et en particulier, celle de «mon camp», celle des personnes qui luttent pour le respect des intérêts des animaux. En effet, la position d'en face, celle qui domine chez les scientifiques, n'est pas sans raisons; et pour pouvoir dialoguer avec ces scientifiques, et avec l'ensemble de la société qui leur fait confiance, et répondre à leurs arguments par des arguments sincères et convaincants, nous devons reconnaître ces raisons. De façon plus générale, le réel nous appartient, autant à nous qu'à quiconque; nous ne devons pas permettre qu'au nom de la science, c'est-à-dire au nom de la réalité, on dénie l'existence ou la pertinence de la sensibilité animale. Nous devons donc prendre conscience des authentiques difficultés qu'il y a à intégrer la sensibilité dans le point de vue scientifique, et commencer à chercher des pistes de résolution.

La question a des incidences directes sur les intérêts des animaux non humains. Florence Burgat rapporte8 la tendance des chercheurs de l'INRA (Institut national de la recherche agronomique) chargés d'étudier la question du bien-être animal à estimer qu'il s'agit d'une non-question, correspondant uniquement à une «demande sociale», c'est-à-dire à une lubie d'un public mal informé (puisque par manque d'esprit scientifique il prend au sérieux l'idée qu'un animal puisse avoir un bien-être). Dès lors, le but de leurs études sera de contenter aux moindres frais cette demande jugée absurde; on mesurera le bien-être de l'animal par sa santé, critère considéré comme «objectif» et lui-même traduit en termes de courbes de croissance et autres indices très peu contraires aux intérêts des professionnels, intérêts jugés, eux, très réels. Dès lors que c'est aux scientifiques que l'on confie le soin d'étudier ce qui est, et que les scientifiques estiment que la souffrance animale n'est pas, ou – ce qui revient au même dans leur esprit – que cette question n'a pas de sens, toute prise en compte sociale sérieuse des intérêts animaux est impossible.

2. Des humains et des cailloux

La thèse centrale de cet article est en quelque sorte double, donnant à la fois tort et raison à chacune de ces deux certitudes. Elle affirme:

— le caractère incontournable du point de vue subjectif et l'impossibilité de ne pas croire au caractère de vérité réelle des assertions éthiques (prescriptives) et à la réalité objective de la sensibilité et de la liberté;

— l'impossibilité d'intégrer la sensibilité et ces autres faits dans la conception de la réalité physique qui domine les esprits encore aujourd'hui.

Ces deux impossibilités aboutissent à une contradiction, dès lors que l'on tient pour acquise cette conception de la réalité physique. Je vais revenir longuement sur chacune, mais je crois aussi qu'il en existe une conscience confuse mais diffuse et tenace dans notre culture. Les deux propositions sont rarement formulées, et la contradiction à laquelle elles mènent rarement mise en lumière. Au lieu de cela, nous faisons dans notre esprit une division du monde en deux compartiments radicalement dissemblables: nous le traitons comme s'il n'était fait que d'humains d'un côté, et de cailloux de l'autre. Les deux propositions contradictoires seront reconnues chacune comme vraie, mais séparément: l'une dans le monde des humains, l'autre dans celui des cailloux.

Reprenons la position «rationaliste» dépeinte ci-dessus par Schrödinger. Elle commence par admettre la sensibilité comme un fait chez les humains: «D'après notre propre expérience, (...) la conscience est connectée...». La conscience, donc, est de l'ordre du fait, chez les êtres humains. Ceux-ci faisant partie du monde physique, on pourrait imaginer que ce même concept de sensibilité soit applicable partout dans ce monde; non que la sensibilité soit nécessairement présente partout, mais que là où elle n'est pas présente, elle soit au moins absente. Mais ce n'est pas cela que dit cette position «rationaliste»; elle nous dit qu'au-delà des limites du monde humain9, la question même de la sensibilité relève de la «spéculation gratuite»; à ce genre de questions «on ne peut pas apporter de réponses». En dehors du monde humain, la sensibilité n'a pas de sens.

Le «rationaliste» de Schrödinger ne nie par contre pas tout à fait que les lois qui gouvernent le monde non humain puissent s'appliquer au monde humain; la sensibilité, dit-il, est connectée à certains types d'événements dans de la matière. Il ne prend cependant guère la peine de détailler cette «connexion»; et si connexion il y a, on ne voit pas pourquoi sa présence ou son absence ne resteraient pas repérables en dehors de l'espèce humaine, y compris «en descendant l'échelle des espèces animales». Il ne semble donc pas tellement persuadé de la possibilité d'établir une telle connexion. D'autres, qui se réclament moins d'un «rationalisme» intégral, feront explicitement de l'«homme» un domaine régi par d'autres déterminismes que ceux qui gouvernent la simple matière; nous sommes corps et esprit, insistent-ils. Telle était la position de Descartes, souvent considéré pourtant comme un des principaux fondateurs de la pensée rationaliste. Aujourd'hui, l'attitude affichée est souvent moins explicite, et relève plus d'une sorte de schizophrénie érigée en dogme; d'un côté on accepte intégralement les lois de la physique moderne, et de l'autre on maintient que ce qui est humain relève d'un autre ordre. C'est là typiquement l'attitude religieuse-laïque; c'est celle que promeut l'Église catholique, et qu'encore aujourd'hui elle reproche à Galilée de ne pas avoir eue, ou pas assez.

La règle générale est d'admettre par principe que l'être humain, système nerveux compris, doit forcément être soumis aux mêmes lois de la physique que le reste de l'univers; mais cette affirmation demeure vide, dépourvue de tout pouvoir opératoire. La complexité du système nerveux sert pour cela à la fois de bonne raison et d'alibi; bonne raison parce que cette complexité est réelle et rendrait impossible l'analyse détaillée, particule par particule, de tous les événements qui se déroulent dans un cerveau; mais alibi parce qu'au-delà de la pétition de principe, on ressent bien, confusément ou clairement, que la complexité ne change rien au fond, et que la sensibilité ne peut tout simplement pas résulter de cette physique qui, pour l'essentiel, décrit le monde comme un ensemble de boules de billard évoluant «mécaniquement», c'est-à-dire selon des lois d'un déterminisme calculable.

Ce partage du monde entre humains et cailloux s'étend pratiquement à la totalité de nos concepts. Au cœur de notre droit il y a la distinction entre les personnes et les choses; tout ce qui n'est pas humain est une chose, tous animaux non humains compris. Au cœur de notre philosophie, l'opposition entre culture et nature; seuls les humains relèvent de la culture, et tout le reste de la nature. Nos universités se divisent systématiquement en disciplines littéraires, qui étudient l'esprit et les «sciences humaines», et en disciplines scientifiques, dites aussi de science dure (comme les cailloux), qui étudient tout ensemble les cailloux, les choux et les hiboux. La sociologie et l'anthropologie relèvent des premières, l'éthologie des secondes, au même titre que la chimie. Entre l'être humain et l'animal, dit-on, il existe un abîme; le premier pense et décide librement, le second est mû par l'instinct comme le caillou par la pesanteur.

Les animaux: grains de sable parmi les cailloux

L'exclusion radicale, cartésienne, des animaux non humains du domaine du sensible est intimement liée à la division du monde en humains et en cailloux; et celle-ci est à son tour liée à la double impossibilité que j'ai mentionnée. La question animale est donc directement impliquée dans la levée de cette double impossibilité.

Si le monde était réellement fait de deux catégories d'objets facilement repérables, une partition conceptuelle absolue ne serait pas indéfendable. Nous pourrions considérer que certains concepts s'appliquent à une catégorie d'objets, mais non à l'autre. Ce serait le cas en particulier des concepts qui fondent notre éthique, nos diverses éthiques. Même sans définition précise les notions de sensibilité, d'autonomie, de dignité, de libre-arbitre et ainsi de suite, nous pourrions constater que tous les signes qui, spontanément, nous font penser d'un être humain qu'il possède n'importe laquelle de ces caractéristiques sont satisfaits par tous les humains et par aucun caillou. Dès lors, face à un objet quelconque du monde, nous n'aurions pas besoin d'autre critère que son appartenance ou non à la catégorie des humains pour décider s'il doit être inclus dans la sphère des patients moraux, c'est-à-dire si nous devons le prendre en compte pour lui-même dans nos décisions.

Tel est le monde tel que le pense l'humanisme, tel que le pense notre culture en général. Pourtant, le monde réel n'est pas fait ainsi, et nous le savons très bien. Déjà au sein de l'espèce humaine, tout le monde ne possède pas, au moins de façon claire, les signes dont j'ai parlé; il existe des embryons et des fœtus, des comateux, des handicapés mentaux profonds. C'est surtout le statut moral des embryons et fœtus qui fait débat, en raison de l'existence d'un enjeu pratique, et aussi d'une continuité évidente dans le développement depuis l'œuf fécondé jusqu'au nouveau-né et au-delà; s'il y a un abîme entre les choses et les personnes, c'est sans bruit et sans efforts que l'embryon semble, on ne sait trop quand, le franchir.

On parvient pourtant maladroitement à contenir cette brèche, en invoquant le fait que les êtres concernés, s'ils ne possèdent pas les caractères des humains adultes typiques, sont au moins destinés à les acquérir (dans le cas des embryons), ou les ont possédés (dans le cas des comateux); ou encore les possèdent par essence, bien que par «accident» ils ne les possèdent pas (dans le cas des handicapés mentaux profonds). La partition du monde en personnes et en choses peut subsister.

Ce sont les animaux non humains qui rendent cette vision intenable. En dehors des êtres humains, il n'y a pas que des cailloux. Le monde n'est pas fait de deux catégories d'objets suffisamment distincts pour que le problème du critère éthique ne se pose pas. Il n'est pas évident qu'un chimpanzé n'est pas sensible, qu'il n'a pas de dignité, ni de libre-arbitre. Et s'il y a un doute pour les chimpanzés, il y en a un pour les chats; et pour les poissons, et pour les poulpes, les fourmis et les méduses, et même peut-être aussi pour les plantes. Le corail est un animal, au demeurant proche de la méduse; mais le corail ne ressemble-t-il pas beaucoup à un caillou? Y aurait-il enfin un doute pour les cailloux? Sans doute que non, mais nous aimerions savoir pourquoi.

La question animale, en mettant simplement le doigt sur l'existence des animaux, et donc d'une continuité au moins apparente entre le monde des êtres humains et celui des cailloux, nous force donc à reconnaître la nécessité d'un critère de patience morale susceptible de s'appliquer à tout objet du monde. Les objets de la physique sont donc, tous, au moins potentiellement, des objets de l'éthique; la question de leur possession de telle ou telle caractéristique pertinente pour l'éthique – et en premier lieu, de la sensibilité – peut, pour chacun d'entre eux, recevoir une réponse positive ou négative, mais n'est jamais dépourvue de sens.

Dès lors, la solution qu'adopte notre société pour «résoudre» la double impossibilité, consistant à séparer chacune dans son propre domaine, ne fonctionne plus. Les deux impossibilités se rencontrent et se heurtent dans un même domaine, celui du non-humain. Nous ne pouvons croire que «se demander jusqu'où, en descendant l'échelle des espèces animales, il y a encore quelque forme de conscience» soit une question dépourvue de sens; nous en aurons besoin pour déterminer si nous avons ou non des obligations morales envers ces objets non humains. Cela sera vrai même si nous adoptons les éthiques les plus hostiles à la prise en compte des animaux non humains; si notre critère est non la sensibilité, mais la possession ou non de la rationalité, par exemple, nous aurons besoin de pouvoir l'appliquer à tout objet du monde, fut-ce pour pouvoir montrer en définitive que seuls les humains sont rationnels.

À partir de là, il ne sert plus à rien non plus de chercher à préserver le domaine de l'humain des atteintes de la physique; nous devons accepter qu'il n'y a qu'un monde, et que nous sommes pleinement de ce monde; et que la sensibilité, ou toute autre caractéristique que nous jugeons pertinente pour l'éthique, est de ce monde, et relève, à ce titre, de la physique. Nous devons reconnaître pour l'éthique et la physique le même domaine d'étude, le même monde. L'éthique se soucie du plus humble caillou, au moins en ce sens que ses critères doivent pouvoir nous dire si et pourquoi nous devons, ou non, nous en soucier.

Les critères de l'éthique doivent s'appliquer à tous les objets du monde physique, et c'est seulement par des moyens physiques que nous pourrons déterminer si ces objets satisfont, ou non, à ces critères. Si notre critère est la sensibilité, nous ne pourrons déterminer si un objet est sensible qu'en l'observant. Et nous savons que tout ce que nous observerons – ses mouvements, les sons qu'il émettra peut-être, et ainsi de suite – sont des faits physiques, et sont reliés, par les lois de la physique, à des processus se déroulant dans l'objet. Si nous pensons que ces faits observés sont des indications de la sensibilité de l'objet, alors même qu'ils sont causés par des processus physiques se déroulant dans l'objet, la sensibilité doit être elle-même un phénomène physique. Le même raisonnement vaut pour tout autre critère éthique que l'on pourrait vouloir se donner.

Une physique en crise

Dès lors, nous n'avons pas de solution au problème de la double impossibilité, sauf celle de réviser nos conceptions de la physique. Dans les prochaines sections, après avoir mis en lumière la première impossibilité, à savoir le caractère incontournable du point de vue subjectif et l'impossibilité de ne pas croire certaines choses, je me tournerai vers les raisons de la seconde impossibilité, celle qu'il y a à intégrer la sensibilité et d'autres objets subjectifs dans la vision dominante de la physique. On pourra penser: d'accord, mais la physique moderne semble presque inattaquable, trop pour que l'on puisse la subvertir à partir du seul problème éthique du statut moral des animaux. Je reconnais la force de la physique moderne. Je sais cependant aussi qu'elle est en crise profonde, qu'elle a perdu ses bases. La solidité qu'on lui accorde généralement correspond pour une part à ses succès pratiques, au formidable pouvoir que nous en tirons pour maîtriser la matière; mais aussi, à sa capacité supposée à fournir une image cohérente et compréhensible du monde. Or, de fait, elle a perdu cette capacité depuis l'avènement de la mécanique quantique dans les années 1920. L'image précédente, aujourd'hui caduque, d'une physique expliquant la réalité est pourtant restée par défaut la vision dominante, l'idéal de la physique, tant auprès du grand public que dans l'esprit de la grande majorité des scientifiques, même de ceux à qui la mécanique quantique est familière. Elle l'est restée précisément parce que la mécanique quantique ne nous donne plus aucune conception crédible de rechange.

Je crois cependant cet idéal classique, celui d'un déterminisme calculable, de type «boules de billard», lui-même incohérent, indéfendable en dernier ressort; parce qu'il est incompatible avec la sensibilité, mais aussi parce que si on porte sa logique jusqu'à son terme, il s'auto-dissout en une pure abstraction mathématique dépourvue de substance. Par conséquent, nous ne devons pas espérer sortir de la crise de la physique moderne, quantique, par un retour au paradigme précédent, comme l'ont rêvé des physiciens tels qu'Einstein aux premiers temps de la mécanique quantique. Nous devons plutôt, je crois, nous appuyer sur les «bizarreries» de la mécanique quantique, et sur les contraintes qui résultent de la réalité de la sensibilité, pour tenter d'imaginer ce que pourrait être une autre conception du monde.

J'exposerai plus loin (section 5) les éléments de la structure de cette physique préquantique qui seront utiles à mon propos. Je ne tenterai par contre pas de brosser un tableau de la mécanique quantique, et ne ferai que me référer quand cela sera utile à quelques-unes de ses caractéristiques. On trouvera dans le commerce de bons ouvrages d'introduction à la mécanique quantique qui permettent de se faire une idée de la structure étrange de cette théorie dont l'interprétation la plus orthodoxe nie l'existence d'une réalité objective10.

Le cri de la carotte

Si la prise au sérieux de la question animale et de la question de la sensibilité a des implications profondes concernant nos conceptions physiques, je pense qu'inversement une réflexion sur la physique, et au moins la conscience de l'insuffisance et de l'incohérence de nos conceptions traditionnelles de la réalité physique, peut permettre de dépasser des débats stériles et d'apporter un début de réponse valable à certaines objections qui nous sont faites. Un exemple est le fameux «cri de la carotte». Au-delà de la mauvaise foi certaine qui la motive, cette objection exprime de façon presque explicite le malaise dû à l'impossibilité d'intégrer la sensibilité dans notre vision du monde physique. On ne nous répond pas «et le cri de la carotte?» si nous plaidons en faveur des Tchétchènes; ceux-ci sont humains, et on ne pose donc pas la question du critère physique justifiant leur prise en compte éthique; elle est automatique. Mais si nous nous préoccupons pour des non-humains, même aussi proches de nous que les cochons ou les vaches, cela montre implicitement que nous ne croyons pas en cette partition; nos critères doivent alors nécessairement être physiques. On nous renvoie donc un phénomène physique – le crissement de la carotte que l'on râpe – en nous sommant de le distinguer d'un cri, de l'expression d'une souffrance, puisque nous ne réservons pas cette notion de souffrance au seul monde humain, mais acceptons qu'elle fasse partie du monde physique, du monde des cailloux.

Aujourd'hui, nous pouvons répondre, bien sûr, que la carotte n'a pas de système nerveux, et ainsi de suite. Mais il faut admettre que dans le fond nous ne savons pas montrer en quoi ces critères ne sont pas arbitraires. Qu'est-ce que le tissu nerveux a de particulier qui en ferait le siège unique d'une souffrance potentielle? Ce qui nous manque, c'est une théorie de la souffrance; et une vision globale du monde physique qui rende cette théorie possible. Dès lors, nous pourrons, effectivement, dire de l'extérieur si tel ou tel phénomène constaté – cri ou crissement, par exemple – correspond ou non à une souffrance, sans plus avoir besoin d'être «dans la peau» de la carotte que nous n'avons besoin d'être dans la peau d'un électron pour déterminer dans quel état il se trouve.

3. L'argumentation par l'impossibilité de ne pas croire

On peut distinguer trois sortes de «raisons de croire» en la vérité d'une assertion:

A. Les raisons démonstratives (informations rendant probable l'assertion; croire que demain il pleuvra, parce que la météo le dit, et que la météo se trompe rarement).

B. Les raisons éthiques (en particulier, pour l'utilitariste, il est juste de croire une chose dès lors que cette croyance augmentera le bonheur total dans le monde).

C. Les raisons causales (toute cause dont la croyance est l'effet; la plupart des gens croient aux dogmes de telle ou telle religion parce que leurs parents et proches y ont cru).

Il peut sembler bizarre de voir une finalité comme raison de croire une chose (raisons de type B.). Pourtant, pour les actes en général, c'est bien généralement une finalité que l'on invoque comme raison de l'accomplir.

On peut penser que le raisonnement idéal en faveur d'une thèse doit être du type A, dont le modèle est peut-être le raisonnement mathématique, où on ne fait pas appel à l'utilité pour le lecteur de croire à la vérité du résultat (ce qui en ferait une argumentation éthique) et où on ne cherche pas non plus par exemple à l'hypnotiser pour qu'il croie en cette vérité («argumentation» du troisième type). Que le lecteur soit content ou non que le carré de l'hypoténuse soit égal à la somme des carrés des deux autres côtés du triangle rectangle, on lui montre qu'il en est ainsi.

Seules les raisons de croire de type A peuvent constituer une réponse valable à une question «pourquoi crois-tu que...?». Une réponse de type «j'y crois parce que cela vaut mieux pour moi (ou pour autrui)» ne peut remplacer une raison de type A11. De même si je réponds que c'est à cause de mon éducation, ou parce que mes neurones sont configurés de telle ou telle manière. De telles réponses peuvent être vraies par ailleurs, mais ne sont pas des réponses à la question posée.

Mon intention est de montrer que les assertions éthiques (prescriptives) correspondent à une vérité objective, et de là montrer en particulier le caractère de réalité objective de la sensibilité et de la liberté. Je serais heureux si je pouvais baser ces développements uniquement sur des raisons de type A. Mais je ne le peux pas.

Vais-je alors me tourner vers une argumentation de type B, et vous donner simplement envie de croire que j'ai moi-même plaisir à croire? Ou encore, trouver moyen de vous persuader par des astuces de rhétorique de la justesse de mes idées? En fait, non. Je crois justifié de faire appel dans le cas présent à une autre forme d'argumentation encore. Elle ne consiste pas à donner une raison de croire, mais à mettre en évidence le fait que nous croyons déjà, et ne pouvons pas ne pas croire12. Dès lors, prendre acte de ce fait n'est qu'une question de cohérence.

On peut trouver faible une telle argumentation, puisqu'elle ne constitue pas une démonstration. Ma réponse est pour une part ad hominem, sans être pour autant, je pense, dépourvue de force. Elle consiste à noter que c'est cette même forme d'argumentation qui fonde en dernier ressort tout ce que nous croyons, à commencer par notre conviction de l'existence d'une réalité.

Ce fait est même universellement reconnu; je vais y revenir dans un instant. Ce qui est remarquable, c'est qu'on n'en fait généralement que peu de cas, considérant l'impossibilité de fonder notre croyance en un monde réel sur un pur raisonnement comme une sorte de curiosité philosophique qui n'enlèverait rien au sérieux de cette conviction; alors que l'impossibilité correspondante dans le domaine éthique – l'impossibilité de fonder la vérité des propositions éthiques sur un pur raisonnement – passe pour la preuve irréfutable du caractère relatif ou conventionnel de celles-ci, ou, pour les personnes religieuses, de la nécessité de les fonder sur la foi en un dieu.

Je pense au contraire que le caractère de vérité des assertions éthiques (prescriptives) est autant fondé que celui des assertions dites «descriptives», portant par exemple sur des réalités matérielles13; les unes comme les autres étant fondées sur la même impossibilité de ne pas croire certaines choses que pourtant nous ne pouvons démontrer. Si l'on estime mon argumentation faible, ce ne peut être plus faible que notre croyance en l'existence du monde; ce qui n'est pas rien.

Avant que l'on ne juge de la faiblesse de cet argument, je voudrais encore que l'on en saisisse bien le sens. L'impossibilité de ne pas croire qui le fonde n'est pas une simple difficulté; elle ne se réfère pas par exemple à la pénibilité psychologique qui accompagnerait une non-croyance. Il s'agit d'une impossibilité constitutive de notre façon d'être au monde. Que l'on se figure cela: que du fait de notre présence même dans le monde, de notre situation d'êtres sensibles, il soit impossible que nous ne croyions pas une chose. Il est alors vain de prétendre ne pas y croire. Toute théorie que nous bâtirions et qui contredirait la croyance en question serait impossible à prendre pour vraie sans croire à la fois une chose et son contraire; c'est-à-dire, serait impossible à prendre sérieusement pour vraie, dès lors que nous prenons conscience de ses implications concernant notre croyance obligée. Cela ne nous interdit sans doute pas de spéculer, en imaginant faux ce que nous ne pouvons pas croire faux; nous pouvons éventuellement tirer des conclusions intéressantes de telles spéculations, mais ne pouvons croire réel le monde ainsi construit.

J'en viens maintenant à la substance de l'argument; mon premier pas sera de mettre en lumière en l'impossibilité qu'il y a pour nous de ne pas croire au caractère de vérité réelle des assertions éthiques (prescriptives).

4. L'éthique

L'impossibilité de ne croire en rien

Nous savons souvent clairement si nous croyons ou non une chose. Je crois que nous sommes en ce moment samedi, et je sais que je le crois. Les choses sont pourtant parfois moins simples. Un bon exemple est la question de la foi dans le christianisme, centrale dans cette religion – la condition nécessaire et suffisante pour être «sauvé» étant de croire en Jésus (en son existence, en son caractère divin, en sa résurrection, etc.). D'où ce dilemme lancinant pour tout chrétien: «Est-ce que je crois vraiment?» La simple affirmation – la «profession de foi» – ne suffit évidemment pas. Le récit de Jésus marchant sur l'eau, et de Pierre coulant parce qu'il n'avait pas cru suffisamment fort pouvoir faire de même14, illustre bien le fait qu'on ne sait pas toujours soi-même si l'on croit ou non une chose ou jusqu'à quel point on la croit; car Pierre s'élance, croyant croire, mais ne croyant en fait pas assez; il coule, et Jésus, avec une certaine perversité, lui lance: «Homme de peu de foi, pourquoi as-tu douté?».

Dans cette histoire, c'est le fait de couler ou non qui, de façon surnaturelle, représente le test de la croyance. Un test plus banal est celui-ci: si nous croyons une chose, cela se traduira dans les décisions que nous prendrons.

Croyons-nous en l'existence d'un monde physique? Je ne parle pas de la validité précise de telle ou telle théorie physique, mais dans un sens minimal. Par exemple, est-ce que je crois, moi, à l'existence du clavier devant moi? Il me semble que la réponse est oui; le fait que je tape sur ses touches, dans le but d'écrire ce texte, s'explique par le fait que je crois que cette action va modifier quelque chose dans le monde. Je ne sais peut-être pas en fait très bien définir ce qu'est le monde, ce qu'est la matière, et quel sens cela peut avoir qu'elle soit modifiée; sauf sur un point: je sais quel sens cela a pour les êtres sensibles. Si je tape sur le clavier, je pourrai lire demain ce que j'ai écrit; et d'autres peut-être le liront. Je crois en l'existence du monde au moins en tant que support à une chaîne causale telle que selon la manière dont j'agis, des êtres sensibles – moi-même, pour le moins – en seront affectés.

Le fait que je tape sur ces touches témoigne donc de ma croyance en l'existence du monde, au moins en ce sens minimal du mot «existence».

Cela, dira-t-on, est banal. Cela signifie cependant que beaucoup de monde croit en l'existence du monde! Tous les êtres sensibles, en fait, à mon avis; mais pour le moment, on admettra que cela paraît plausible au moins pour tous les êtres humains adultes typiques – non en état de coma, par exemple. Ils mangent, ils croient donc en l'existence de ce qu'ils voient dans leur assiette, ou au moins au fait que de quelque manière les mouvements qu'ils font leur apporteront ou leur enlèveront quelque sensation, de plaisir ou de faim.

Conclusion banale, certes, mais qui contredit une tradition qui remonte au moins jusqu'au sceptique grec Pyrrhon (IVe-IIIe siècle avant J.C.), lequel disait douter de l'existence même de ce monde. Selon Diogène, Pyrrhon croyait si peu au témoignage de ses sens qu'il n'évitait de tomber des falaises que grâce à l'intervention de ses amis**. C'est là un cas bien rare; pourtant, si ce récit témoigne sans doute d'une non-croyance chez ce philosophe en l'existence de la falaise (si l'on écarte les soupçons sur ce qu'il aurait fait en l'absence de ses amis), il n'implique pas la non-croyance dans le monde en général, au contraire; car pourquoi donc Pyrrhon mettait-il un pied devant l'autre, si ce n'était pour avancer, ou au moins pour soulager l'envie de bouger – laquelle impliquait déjà une croyance en un effet, jamais tout à fait immédiat, de ses actes?

De fait, Descartes, reprenant cette même question de la fondation ultime de nos croyances en l'existence du monde, commença par «douter» de tout; mais ce doute n'était chez lui que provisoire, heuristique, et n'impliquait pas de conséquences pratiques15:

(...) avant de commencer à rebâtir le logis où on demeure (...) il faut aussi s'être pourvu de quelque autre où l'on puisse être logé commodément pendant le temps qu'on y travaillera; [donc] afin que je ne demeurasse point irrésolu en mes actions pendant que la raison m'obligerait de l'être en mes jugements et que je n'en laissasse pas de vivre dès lors le plus heureusement que je pourrais, je me formai une morale par provision, qui ne consistait qu'en trois ou quatre maximes <(...).

Ces «trois ou quatre maximes» pratiques sont empreintes d'un solide bon sens et visent, comme le dit Descartes, à son bonheur, c'est-à-dire à une sensation. Descartes fait découler l'action de la croyance (le «jugement»), puisqu'il craint de demeurer «irrésolu en [ses] actions pendant que la raison [l]'obligerait à l'être en [ses] jugements»; pourtant, il affirme pouvoir suppléer à cette absence de croyance par une morale «par provision» (provisoire). Il semble clair pourtant que cette morale suppose forcément elle-même une croyance. La première, par exemple, «était d'obéir aux lois et coutumes de mon pays»; il croyait donc en l'existence de ce pays. Descartes n'a ainsi jamais réellement cessé de croire en la réalité du monde; il n'a jamais été irrésolu en ses jugements sur ce point, son doute, provisoire, ne portant que sur leurs fondements.

Par ces exemples je veux suggérer que l'existence d'un scepticisme philosophique ou autre quant à l'existence du monde n'implique pas celle d'un doute réel sur ce sujet. Il ne s'agit pas pour moi de dire que ces personnes sont de mauvaise foi. Descartes lui-même ne prétendait pas vraiment avoir cru à l'inexistence du monde. D'autres ont sans doute cru croire, mais, je pense, n'ont eux non plus jamais cru16.

Mais mon propos n'est pas simplement de constater que tel ou tel n'a pas réellement douté de tout, ni même d'affirmer que personne n'a jamais nourri réellement un tel doute; il est de montrer qu'un tel doute est impossible, du fait de notre situation – situation qui est celle de tout être délibérant, et donc, je crois, de tout être sensible.

Notre situation est que nous devons à chaque instant décider. Ce n'est pas que nous avons intérêt à décider; c'est qu'il est impossible que nous ne décidions pas.

Supposons que nous ne croyions en rien. Nous ne croyons alors pas que notre action aura tel ou tel effet. Pourquoi alors nous fatiguer à agir? Nous pourrions aussi bien rester à ne rien faire. Mais pourquoi ne rien faire? Pour moins nous fatiguer? Si nous ne croyons en rien, nous ne croyons pas non plus qu'agir nous fatiguera, ni que ne pas agir nous fatiguera moins.

Nous ne pouvons non plus décider sans raisons. Lorsque nous sommes irrésolus, nous cherchons une raison pour décider d'une manière ou d'une autre; nous ne pouvons décider qu'avec une telle raison. Pourtant, tant que nous demeurons irrésolus, nous avons au moins décidé une chose – à savoir, de ne rien décider d'autre. Nous pourrions courir dans tous les sens, ou prendre une quelconque autre décision; si nous ne le faisons pas, c'est bien que nous avons une raison de ne pas le faire, si ce n'est que, par exemple, pour ne pas nous fatiguer inutilement. Descartes, pour ne pas «demeurer irrésolu», adopte une morale, c'est-à-dire un système de raisons pour décider d'une façon ou d'une autre; mais il ne choisit pas n'importe quelle morale. En même temps qu'il expose ses «trois ou quatre maximes», il les justifie; par des raisons pratiques, «raisonnables» comme on dit, auxquelles de toute évidence il croit, malgré le «doute» que lui impose la raison.

Descartes croit donc en des raisons pour décider, au sens «factuel»; c'est-à-dire qu'il croit en l'existence d'un certain pays, celui où il réside, en l'existence de ses lois et coutumes, etc. Mais il croit en ces raisons aussi au sens prescriptif: il croit que ce sont là des raisons pour décider de se comporter de telle ou telle manière. Il croit en l'existence de raisons prescriptives.

En somme:

— il nous est à chaque instant impossible de ne pas prendre de décisions;

— nous ne pouvons prendre de décisions sans croire en des raisons pour les prendre (raisons prescriptives);

— il nous est donc impossible de ne pas croire en des raisons pour prendre des décisions (raisons prescriptives).

Points de vue intérieur et extérieur

Je crois bon d'insister ici quelque peu sur la position à partir de laquelle on aboutit à cette conclusion. Il s'agit de ce que j'appelle le «point de vue intérieur ». On pourrait imaginer décrire les mêmes événements – une personne en train de délibérer, puis de décider et d'agir – d'un point de vue extérieur, comme un système physique traversant une suite d'états en fonction de certaines lois. Peut-être identifierons-nous alors certains de ces états comme étant des croyances en ceci ou cela; et constaterons-nous que le système est toujours dans un état de croyance en quelque chose, et que cet état est déterminant pour l'évolution ultérieure du système (détermine son action future). Sans doute chercherons-nous aussi à expliquer cet état de croyance, par le jeu des lois du mouvement des atomes, ou, à un autre niveau, par les mécanismes darwiniens d'évolution. Ce point de vue extérieur est valable dans son principe, puisque nous sommes dans le monde, et sommes donc des systèmes physiques; ces descriptions et explications sont forcément possibles. Cependant, pour légitime qu'il soit, le point de vue extérieur ne peut abolir le point de vue intérieur. Le point de vue extérieur constate et explique notre croyance; mais le constat et l'explication de notre croyance ne sont pas notre croyance, et n'abolissent pas, de par leur simple existence, notre croyance.

Il arrive cependant que la manière dont nous constatons et expliquons une de nos croyances constitue une raison de ne plus y croire; par exemple lorsque nous expliquons une illusion d'optique. Il se peut alors que nous abandonnions cette croyance. Mais il se peut aussi que ce ne soit pas le cas, et que nous n'abandonnions pas cette croyance, parce que nous n'avons pas été convaincu par l'explication, ou parce qu'elle ne nous paraît pas réellement contraire à la croyance, ou pour toute autre raison; en tout état de cause, nous ne devons pas nous persuader nous-même que nous ne croyons pas, tant qu'en réalité nous croyons. Et telle sera toujours la situation concernant certaines choses, si, comme je l'affirme, il nous est impossible de ne pas y croire, du fait de notre condition d'êtres délibérants.

Un reproche souvent fait à l'encontre des descriptions et explications scientifiques des phénomènes subjectifs est celui de «réductionnisme». Je pense que ce reproche est, dans le fond, juste; non que nous ne devions pas décrire et expliquer ces phénomènes en des termes scientifiques, ni qu'il faille ajouter à cela, comme on cherche souvent à le faire, une couche holistique de «phénomènes émergents» basés sur le principe contestable selon lequel le tout serait plus que les parties. Je crois plutôt que ces descriptions et explications sont elles-mêmes faites dans les termes d'une physique en réalité incompatible avec les phénomènes subjectifs, et que les accepter reviendrait à accepter que ce point de vue extérieur puisse abolir le point de vue intérieur. Or cette abolition, comme je l'ai dit, n'est pas possible. Une physique qui a des implications auxquelles nous ne pouvons pas croire est elle-même une physique à laquelle nous ne pouvons pas croire.

La réalité de la valeur de vérité des assertions prescriptives

En première ligne parmi les choses auxquelles nous ne pouvons pas ne pas croire se trouve l'existence de raisons pour prendre des décisions, c'est-à-dire l'existence de la bonne réponse à la question «Que faire?». Les réponses (bonnes ou mauvaises) à cette question sont des assertions non pas descriptives, au sens classique du terme, mais prescriptives. Elles sont de la forme «Faire telle chose!». Elles ne s'identifient pas à une simple prédiction, du type «Je ferai telle chose».

On pourra trouver mystérieuse cette nouvelle catégorie d'assertions. Quelle est leur valeur de vérité? En quel sens la proposition «Faire telle chose!» peut-elle être vraie? Tout d'abord, un telle proposition a bien une négative: «Ne pas faire telle chose!». D'autre part, la croyance ne constitue pas en elle-même la vérité de ces propositions; nous sommes susceptibles de nous tromper. Après avoir pensé «Faire telle chose!», nous pouvons nous raviser: «Non, au contraire, faire telle autre chose!». Nous pouvons aussi nous raviser après coup: «Je n'aurais pas dû faire telle chose.» Si la croyance en l'assertion constituait sa vérité, nous ne pourrions pas changer d'avis, c'est-à-dire estimer avoir eu tort; et l'acte de délibération lui-même n'aurait aucun sens – toute conclusion à laquelle nous aboutirions serait de ce fait même juste. Ce serait comme décider de chercher dans un pré le brin d'herbe que l'on y aura trouvé.

Si la valeur de vérité des assertions prescriptives n'est pas constituée par le fait que nous croyions en leur vérité, c'est qu'elle existe indépendamment de notre opinion sur le sujet. Chercher la bonne réponse à «Que faire?», c'est nécessairement supposer qu'une certaine réponse est la bonne, qu'on la trouve ou non. Cela n'aurait pas de sens de la rechercher si nous ne croyions pas cela; mais il est impossible que nous ne la cherchions pas, et il est donc impossible que nous ne croyions pas qu'une certaine réponse est bonne, indépendamment de notre perception de ce fait. C'est en ce sens que nous ne pouvons pas ne pas croire en la réalité de la valeur de vérité des assertions prescriptives.

Fins et moyens

Il ne faudrait pas croire que la délibération se résumerait à une recherche purement factuelle, du genre «Sachant que j'ai telle fin, quel est le meilleur moyen pour y parvenir?». Si tel était le cas, ce que j'appelle «assertion prescriptive» se réduirait à une assertion descriptive, au sens habituel: «Sachant que j'ai telle fin, faire telle chose est le meilleur moyen pour y parvenir». Mais nous choisissons aussi nos fins. Même un être tout à fait «égoïste» choisit de ne prendre en compte que ses propres intérêts, à l'exclusion en particulier de ceux des autres. Cela implique au minimum qu'il croie au caractère factuel de l'éventuelle satisfaction future de ses intérêts, c'est-à-dire, s'il conçoit ses intérêts en termes d'obtention de plaisir et de non-souffrance, qu'il croie en la réalité de son plaisir et de sa souffrance17. Il ne peut croire que constituent une fin pour lui des choses qui, en réalité, n'existent pas. Mais il devra aussi croire que ce plaisir et cette souffrance futurs peuvent résulter de ses propres actes; il devra donc croire en l'existence d'un monde physique, au moins en ce sens minimal. Enfin, la satisfaction de ses propres intérêts représentera au moins dans la plupart des cas non une fin, mais plusieurs finalités au moins partiellement contradictoires; il devra choisir entre des plaisirs qualitativement différents, entre des plaisirs proches dans le temps et d'autres lointains, décider si tel plaisir vaut telle souffrance nécessaire pour l'obtenir...

On peut imaginer aussi que les «intérêts» d'un individu soient définis par lui-même en d'autres termes que le plaisir et la souffrance; deux exemples sont l'idée (résultant d'une mauvaise interprétation du darwinisme) selon laquelle nos «vrais» intérêts seraient la propagation de nos gènes; et celle d'un certain individualisme romantique pour qui il s'agirait par exemple de «nous réaliser nous-mêmes»18. Si certaines personnes prennent vraiment au sérieux de telles finalités, cela ne fait que confirmer la pluralité de nos fins possibles, et donc le fait que celles-ci, comme nos moyens, résultent d'un choix.

Je crois qu'en réalité cette séparation entre choix des fins et choix des moyens est artificielle. Dans nos délibérations réelles les deux sont intimement mêlés. Sans doute la tentation de postuler une telle séparation et de chercher à éliminer le choix des fins en faisant de celles-ci des constantes vient-elle de notre difficulté à concevoir sur quelles bases ce choix pourrait se faire, dès lors qu'il est libre. Je reviendrai sur le problème du libre-arbitre. Je voudrais seulement suggérer ici que le choix des moyens, dès lors que les fins seraient fixées, n'est pas forcément moins problématique quant à son mécanisme. Les solutions trouvées pour atteindre une fin donnée sont souvent «innovantes», et les hypothèses avancées par Penrose suggèrent que notre cerveau permet des modes de résolution des problèmes qui ne pourraient être simulés par un algorithme, et ne sont donc pas déterministes au sens du déterminisme calculable.

Un sens «pour moi»?

Nous ne pouvons nous abstenir de décider, et ne pouvons décider sans nous demander «Que faire?»; et nous ne pouvons nous poser cette question, comme n'importe quelle question, que si nous lui accordons un sens.

Nous ne pouvons pas dire, «oui, j'accorde un sens à cette question, mais c'est parce que ne peux faire autrement; mais je ne crois pas qu'elle en possède un réellement». Si nous ne croyons pas qu'elle a réellement un sens, nous ne croyons pas qu'elle en ait un du tout.

Nous ne pouvons pas non plus dire, «oui, elle a un sens, mais seulement pour moi». Ce procédé de relativisation est souvent utilisé aussi concernant les assertions «descriptives» au sens classique. Il me semble bon d'en examiner la signification.

«Pour moi» peut vouloir dire «c'est là ce que je crois»; alors «x a un sens pour moi» signifie «je crois que x a un sens (mais d'autres, peut-être, ne le croient pas)». L'assertion selon laquelle x a un sens n'est alors pas elle-même relative, mais absolue. Je peux dire, «pour moi la terre est plate»; la platitude de la terre reste une question absolue: elle est vraie ou fausse indépendamment de moi. Affirmer que les assertions prescriptives ont un sens pour un certain individu, c'est alors affirmer que cet individu croit qu'elles ont un sens absolu; et c'est bien là ce que j'ai voulu montrer: nous croyons tous que les assertions prescriptives ont un sens.

Dans d'autres cas, le «pour moi» dénote un autre type de relation entre l'énoncé et un certain individu. Une pomme peut avoir un goût sucré pour Anne, et acide pour Valérie; son «goût objectif» n'existe alors pas. Cela ne signifie cependant pas que le goût qu'il a objectivement pour Anne n'existe pas, comme celui qu'il a pour Valérie! Dans le cas qui nous occupe, on pourrait donc dire que l'avoir-un-sens de x est une vérité objective, mais en relation avec moi. Cette relation pourrait être le simple fait qu'effectivement, c'est moi qui crois que x a un sens; nous retrouvons alors la première interprétation du «pour moi». La relation pourrait aussi être le fait que l'assertion prescriptive x est elle-même clairement en relation avec l'entité «moi», du moins si on admet l'existence d'une telle «identité personnelle»19: elle prescrit ce que je dois faire. Il s'agit d'une vérité me concernant, en ce sens; mais d'une vérité à laquelle je crois, tout comme je crois (ou non) à la platitude de la Terre.

Il est remarquable que cette relativisation – ce «vrai pour moi» – fonctionne comme si «moi» était une entité en quelque sorte extérieure au monde, et pouvait à ce titre en quelque sorte emmener dans sa retraite la vérité elle-même dont il s'agit. Dès lors que nous faisons partie du monde, notre point de vue lui-même sur le monde en fait partie. Si nous croyons que les assertions prescriptives ont un sens «pour nous», nous croyons qu'elles ont un sens tout court.

L'éthique comme théorie de la réponse vraie à «Que faire?»

J'ai jusqu'à présent parlé d'assertions prescriptives; je crois que nous pouvons aussi les appeler assertions éthiques. Plus exactement, je pense qu'une assertion prescriptive – l'assertion «Faire telle chose!» – est vraie si la chose qu'elle commande de faire est celle que nous commande de faire l'éthique; et par conséquent que la délibération – le fait de se poser la question «Que faire?» – est la recherche de l'action éthiquement juste.

Je ne le dis pas dans un sens normatif; c'est-à-dire, je n'affirme pas que toute délibération devrait être la recherche de l'action éthiquement juste. Je dis que de fait elle l'est. Je pense que l'éthique doit se définir ainsi: comme théorie de la réponse juste (vraie) à la question «Que faire?».

On me dira que je suis libre de définir mes mots comme je l'entends, mais que mon «éthique» n'est tout simplement pas l'éthique au sens courant du terme. Je ne crois pas une telle objection justifiée. Plus exactement, je crois que la définition que je donne de l'éthique découle de l'usage habituel du terme, dès lors que l'on cesse de faire une exception arbitraire concernant les décisions qui ne concernent que soi-même, et que l'on admet le caractère de vérité absolue des assertions prescriptives.

On oppose généralement comportement égoïste et comportement éthique. L'éthique aurait justement pour fonction de nous amener à penser aux autres, à respecter leurs droits et leurs intérêts, plutôt que de ne penser qu'à nous-mêmes. Certaines conceptions éthiques sont explicitement restrictives concernant leur domaine d'application; les théories contractualistes, par exemple, nous enjoignent, pour l'essentiel, de respecter les termes de notre «contrat» avec autrui, mais en dehors de cela, nous laissent «libres» de faire «selon notre bon vouloir»20. Une théorie éthique au moins, cependant, régit en principe la totalité de nos choix, en mettant sur un pied d'égalité ceux qui concernent nous-mêmes et ceux qui concernent autrui. En effet, pour l'utilitarisme hédoniste, nous devons agir pour maximiser le bonheur net dans le monde; dès lors, un acte augmentant notre propre bonheur sans affecter celui d'autrui est éthiquement obligatoire, au même titre que peut l'être un acte augmentant le bonheur d'autrui.

Ce fait est rarement perçu, peut-être tout simplement parce qu'il y a peu besoin de commander aux gens de rechercher leur propre bonheur. Un tel commandement reste pourtant de nature éthique, même si nous y adhérons en général sans le secours d'une théorie éthique construite. Il en est de même pour beaucoup de propositions de la physique; nous n'avons pas besoin de la mécanique des fluides pour boire un verre d'eau. La physique n'en serait pas moins artificiellement mutilée si nous retirions de son domaine de compétence ce qui se passe quand nous buvons un verre d'eau; tout comme c'est une mutilation artificielle de l'éthique que d'en retirer les prescriptions «évidentes» comme celles qui nous commandent de tenir compte de nos propres intérêts.

Parmi les théories éthiques fréquemment mentionnées, il y en a une autre au moins qui nous donne des obligations dans les choix ne concernant que nous-mêmes. Il s'agit de ce qu'on appelle «l'éthique égoïste», dont le commandement unique est: maximise ton propre bonheur. Le fait qu'elle soit fréquemment mentionnée en tant qu'éthique, même comme «cas d'école»21, montre que l'usage n'exclut pas, au moins en théorie, du champ de l'éthique les décisions ne concernant que nous-mêmes. Cette éthique égoïste, tout comme l'utilitarisme hédoniste, gouverne en principe la totalité de nos choix.

Cependant, la raison fondamentale qui me fait dire que l'éthique doit se définir comme la théorie générale de la réponse vraie à «Que faire?» est le fait que toute délibération est fondamentalement altruiste. Même si je suis en train de ne penser qu'à «moi-même», je pense nécessairement à un «moi-même» futur. Mes actes ne peuvent déterminer le plaisir ou la souffrance que j'éprouve au moment où je les choisis; ils détermineront forcément mon plaisir ou ma souffrance futurs. Nous sommes habitués à trouver évidente la préoccupation que nous avons pour nous-mêmes. Le problème fondamental de justification de l'éthique nous semble être «pourquoi devrais-je, rationnellement, me préoccuper d'autrui?»; et c'est une question que beaucoup estiment dépourvue de réponse. Il est bien rare par contre que nous nous demandions «pourquoi devrais-je, rationnellement, me préoccuper du bonheur ou du malheur que j'éprouverai dans cinq minutes?». Nous pouvons pourtant tout aussi bien déclarer que ce bonheur ou malheur futur nous est totalement indifférent! Il est rare que l'on soit totalement indifférent à ce que l'on éprouvera dans cinq minutes, tout comme il est rare que l'on soit totalement indifférent au sort des personnes proches; par contre, il est fréquent que l'on soit assez indifférent à ce que l'on éprouvera dans trente ans. Si ce n'était pas le cas, la consommation de tabac s'en ressentirait.

L'idée selon laquelle il y aurait une différence radicale entre le souci pour ses propres intérêts – forcément futurs – et celui pour les intérêts d'autrui me semble donc une construction dogmatique et artificielle, peu justifiée tant au niveau théorique que pratique. C'est en ce sens que je crois que toute délibération est altruiste; les intérêts qu'elle prend en compte sont toujours ceux d'un «autre», que cet autre soit un autre individu, ou un soi-même futur.

«J'ai du mal à y croire»

Il reste une objection à cette conception de l'éthique: nos décisions ne sont pas, de fait, toujours conformes à l'éthique, même à l'éthique à laquelle nous-mêmes adhérons. Il est parfaitement possible de dire «je reconnais que je devrais faire telle chose, mais je ne parviens pas à m'y résoudre»22.

Je crois cependant que cette objection tombe si nous envisageons les assertions prescriptives comme possédant une valeur de vérité réelle, indépendante de la connaissance que nous en avons. Ce n'est pas notre adhésion verbale à une prescription qui en fait la valeur de vérité; ce n'est pas non plus le fait que nous croyions y adhérer.

Il peut être utile de faire le parallèle avec les assertions descriptives, au sens classique. Quand un parachutiste débutant ne parvient pas à sauter dans le vide, n'est-ce pas parce qu'il n'est pas tout à fait convaincu que cet acte est sans danger? Il pourra bien protester qu'il sait que cela est sans danger; et il pourra repasser cent fois dans sa tête les données qui devraient le rassurer. Mais il faut bien croire que «quelque chose en lui» continue à croire au danger. Il me semble que cela implique pour le moins que nous ne sommes pas tout à fait des «individus», des atomes. Si je crois que la conscience n'est pas une illusion (à quels yeux le serait-elle?), il me semble que son unité, par contre, est illusoire, au moins en partie. Par conséquent, le fait qu'une partie de notre conscience soit convaincue d'un fait n'interdit que d'autres parties soient convaincues du contraire.

Nous savons souvent sans savoir. «J'ai du mal à y croire» dit-on souvent au sujet de la mort d'un proche. Il se peut bien en effet que nous agissions parfois comme si ce proche était encore là; que nous mettions encore le couvert pour lui, «par distraction» – ou plutôt, parce qu'une partie de nous ne croit toujours pas en sa mort.

Pour revenir aux assertions prescriptives: nous pouvons bien savoir que ce que nous allons faire n'est pas ce que nous devrions faire; parce que, par exemple, cela va faire souffrir autrui, plus que cela ne va nous faire plaisir. Mais nous le savons sans le savoir entièrement; tout comme nous savons, par exemple, que le plaisir de cette cigarette nous fera peut-être beaucoup souffrir plus tard, tout en ayant du mal à y croire. C'est donc bien parce qu'une partie de nous ne croit pas vraiment à ce que, pourtant, nous croyons croire que nous agissons en contradiction avec ce que nous croyons croire; et ceci est vrai, que ce que nous croyons croire soit de l'ordre du descriptif (au sens classique), ou du prescriptif.

Il y a quelques mois je suis monté au sommet d'une des tours de la Basilique de Fourvière à Lyon. Cette tour, ouverte aux visites, est gravie par des centaines de personnes tous les jours, depuis des lustres; je savais qu'elle n'allait pas s'écrouler simplement parce que je mettais un pied de travers! Tout me démontrait que la probabilité en était infime. Pourtant, j'eus le vertige en grimpant les marches; un vertige rempli de craintes de l'écroulement de l'édifice. Je posais le pied doucement, de peur de faire des chocs. Je suis arrivé au sommet, mais les dents serrées. Cette peur était sans doute irrationnelle, elle n'en était pas moins réelle; elle correspondait bien à une croyance réelle en moi, celle de courir un danger.

Je ne vois pas de difficultés à considérer le problème de la non-observance de nos propres croyances éthiques sous le même angle. Nous n'y croyons, tout simplement, qu'en partie.

Description et prescription

Ma thèse est que nous croyons aux prescriptions comme nous croyons aux descriptions; nous croyons ce qu'elles nous disent vrai (ou faux). J'utilise encore à leur sujet d'expressions comme «vérité objective», «réalité». Une phrase célèbre – dont je ne retrouve pas l'origine, et que je cite de mémoire – disait en substance qu'on ne trouve nulle part dans l'univers quelque chose qui ressemblerait à une prescription; et que les prescriptions, par conséquent, n'existent pas en soi. Les devoirs moraux, le bien et le mal, ne seraient que le fruit de nos préférences personnelles «subjectives», d'origine culturelle ou autre. Il n'y aurait pas de vraie éthique.

J'admets ne pas pouvoir définir clairement moi non plus en quel sens les prescriptions éthiques sont des objets réels. Je crois cependant que l'idée généralement reçue sans discussion selon laquelle les objets «matériels», eux, existent, est largement aussi problématique. Le verbe «exister» semble transparent, mais la transparence rejoint l'opacité dans le fait de ne laisser voir aucun contenu. De fait, dans la physique moderne, quantique, la question de l'existence même d'une réalité objective est devenue d'une grande opacité; la position «standard» (dite «de Copenhague») est qu'elle serait elle-même dépourvue de sens. La physique ne serait qu'un ensemble de «recettes» permettant de prédire les observations futures à partir des observations passées. Tout le reste ne serait que «spéculation gratuite»23. Paradoxalement, selon cette interprétation, l'utilité (humaine), objet subjectif, voire prescriptif, reste seule en lice – la réalité physique a disparu, animaux non humains compris.

La mécanique classique, préquantique, que j'appelle «laplacienne», semble, elle, donner à la réalité physique une plus grande consistance. C'est elle, comme je l'ai dit, qui est restée une sorte d'idéal de la physique, y compris auprès d'esprits scientifiques, avides d'une croyance en une réalité dure et froide. On perçoit donc peu à quel point, en fait, la logique même de la physique laplacienne conduit elle aussi à une dissolution de la notion de réalité. Je vais consacrer la section suivante à une description sommaire de cette conception laplacienne du monde, et à mettre en relief quelques-unes de ses faiblesses.

En tout état de cause, je voudrais que l'on suspende quelque peu les certitudes habituelles selon lesquelles pour être «réelle», une «chose» doit être faite en matière et se trouver «quelque part dans l'univers». Nous ne savons pas bien ce qu'est être réel pour un caillou. Nous ne savons pas non plus très bien en quel sens les vérités mathématiques existent. Je ne saurais non plus dire précisément en quel sens les assertions prescriptives existent. Je sais seulement que l'on ne peut ôter toute existence ni aux cailloux, ni aux vérités mathématiques, ni aux vérités éthiques. Je crois que ces choses existent dans le monde, et donc y existent objectivement, y sont réelles. Je ne ferai pas de distinctions nettes entre ces notions, parce que je ne crois pas à celles que l'on fait habituellement.

En particulier, je pense que si une assertion prescriptive, de la forme «Faire telle chose!», est vraie, c'est qu'elle décrit une réalité. On oppose classiquement le descriptif et le prescriptif; je pense au contraire que toute assertion est descriptive. C'est pourquoi aussi je parle d'assertions descriptives «au sens classique» pour celles que l'on considère habituellement comme telles (sur la masse des cailloux, par exemple).

Les animaux en tant qu'agents moraux

Dans les théories morales antispécistes, il est courant de distinguer la notion d'agent moral de celle de patient moral. Les humains sont généralement à la fois agents moraux, c'est-à-dire qu'ils peuvent (et doivent) agir de manière éthique, et patients moraux, c'est-à-dire qu'on doit tenir compte d'eux (de leurs intérêts, droits, dignité...) lors d'une décision éthique. En revanche, les animaux non humains ne sont généralement considérés que comme patients moraux: on doit se soucier d'eux, autant que des humains, mais ils n'ont pas de devoirs, parce qu'ils ne sont pas capables de raisonner à un niveau éthique, tout comme les jeunes enfants humains par exemple.

Si l'on accepte par contre, comme je le propose, que toute délibération est par définition une recherche éthique, et qu'il n'y a pas de différence de nature entre la prise en compte par l'individu délibérant de ses propres intérêts (futurs) et des intérêts d'autres êtres, on conçoit que tout animal, dès lors qu'il délibère, est un agent moral, dans le même sens où un humain peut l'être.

Cela ne signifie pas qu'il n'y ait pas à faire de distinctions dans le niveau de complexité et d'abstraction que peut atteindre un individu dans son raisonnement éthique. Il en va pour l'éthique comme pour la physique. Les animaux qui délibèrent sont aussi nécessairement des physiciens; ils prévoient des conséquences à leurs actes. Seuls quelques-uns parmi eux, à savoir certains humains, peuvent bâtir des théories physiques et/ou éthiques complexes et abstraites; bien plus souvent, l'horizon éthique et physique est plus restreint; on s'en tient aux choses que l'on voit, à l'avenir immédiat, à ses propres intérêts prochains et à ceux de sa famille ou de son groupe. Cette éthique et cette physique limitées n'en sont pas moins une éthique et une physique.

Nos cris de peur et de douleur disent: «Ce n'est pas bien!» Les cris du cochon que l'on égorge disent la même chose: que ce n'est pas bien. C'est ce que dit aussi l'antispéciste; il dit que ce n'est pas bien, pour les mêmes raisons que le dit le cochon. Cette même proposition, dans des bouches différentes, a le même sens et la même nature; c'est une proposition éthique.

Si l'on en croit les paroles que l'écrivain végétarien J.M. Coetzee met dans la bouche d'un de ses personnages24, c'est l'éthique d'une poule qui, en partie, fit abolir la peine de mort en France:

Pour ce qui est de l'idée selon laquelle les animaux seraient trop muets et stupides pour parler en leur propre nom, pensons à la séquence d'événements suivante. Quand Albert Camus était enfant en Algérie, il advint que sa grand-mère lui demanda d'aller lui chercher une poule dans les cages de la cour. Il obéit, et vit ensuite sa grand-mère couper la tête de la poule avec un couteau de cuisine et recueillir le sang dans un bol pour éviter de salir par terre.

Le cri d'agonie de la poule s'imprima dans la mémoire de l'enfant et ne cessa de le hanter au point de l'amener à écrire en 1958 une dénonciation passionnée de la guillotine. Ce fut en partie suite à cette polémique que la peine de mort fut plus tard abolie en France. Qui peut donc dire que la poule ne pouvait pas parler?

5. Le modèle laplacien de la réalité

Ce que j'appelle modèle classique, ou laplacien, de la réalité naquit au XVIIe siècle avec Galilée et Newton, en remplacement de la physique d'Aristote dominée par les idées finalistes, animistes, de nature et de finalité des corps. Le modèle laplacien constitua le socle du rationalisme scientifique et domina la vision scientifique du monde jusqu'au début du XXe siècle. La théorie de la relativité d'Einstein (1905, 1915) se place encore dans ce cadre, qui ne fut subverti que dans les années 1920, par la mécanique quantique – laquelle le rendait intenable, sans pour autant apporter de vision alternative de la réalité physique.

Je pense que l'on se rendra compte, en lisant la courte analyse que je vais faire ici de ce modèle, que c'est bien celui que nous tendons «spontanément» à voir comme le modèle de description scientifique. Lorsque nous tenons absolument, par exemple, à rejeter l'idée de libre-arbitre parce qu'il «faut bien» que nos choix soient déterminés par quelque chose, cette exigence n'est évidente ni dans le cadre aristotélicien, ni dans celui de la mécanique quantique, laquelle implique que certains événements se produisent effectivement sans raison. Je ne crois pas non plus le modèle, ou plutôt non-modèle, que nous donne la mécanique quantique satisfaisant pour rendre compte du libre-arbitre; mais je voudrais au moins que l'on accepte de relativiser quelque peu les postulats du modèle laplacien. Je montrerai d'ailleurs en quoi ce modèle ne satisfait pas lui-même à ses propres exigences qui voudraient que tout arrive pour une raison.

J'appelle ce modèle «laplacien» en référence à cette formulation frappante que le physicien Pierre Simon de Laplace (1749-1827) donna de la notion de déterminisme25:

Une intelligence qui, pour un instant donné, connaîtrait toutes les forces dont la nature est animée et la situation respective des êtres qui la composent, si d'ailleurs elle était assez vaste pour soumettre ces données à l'analyse, embrasserait dans la même formule les mouvements des plus grands corps de l'univers et ceux du plus léger atome: rien ne serait incertain pour elle, et l'avenir, comme le passé, serait présent à ses yeux.

Dans cette vision des choses, la réalité – tout ce qui existe – est constituée d'une collection finie ou infinie d'objets – les «êtres» dont parle Laplace – dont chacun peut être caractérisé par un certain nombre de propriétés éventuellement variables dans le temps; la connaissance à un instant donné de la liste de ces objets et de leurs propriétés constitue une description complète de la réalité en cet instant.

Une image simplifiée que j'utiliserai souvent est celle des boules de billard. Dans un jeu de billard idéalisé, en effet, les boules se meuvent à tout instant suivant une loi parfaitement définie et calculable. Tant qu'elles ne rencontrent pas une paroi ou une autre boule, elles se meuvent en ligne droite à vitesse constante; lors d'une collision, elles rebondissent de manière élastique, suivant une loi simple qui met en jeu leurs caractéristiques intrinsèques (masse, rayon), leur mouvement et leur position. L'évolution de l'ensemble peut être complexe, si un grand nombre de boules sont en jeu, mais reste toujours entièrement prévisible, au moins en théorie, par une «intelligence», comme l'appelle Laplace, qui connaîtrait les lois du mouvement ainsi que la masse et la situation (position, vitesse) de chaque boule. L'image «boules de billard» du monde suppose que le monde entier n'est qu'une vaste collection de telles boules se mouvant dans l'espace à trois dimensions.

Bien entendu, la physique classique n'a jamais sérieusement proposé une vision aussi simpliste des choses. L'image «boules de billard» reste cependant valable, parce que la physique classique se ramène bien, conceptuellement, à une telle image, à quelques nuances près. Dans la physique classique, nous n'avons pas des boules, mais des «points matériels» – «atomes» ou «particules» sans dimensions, mais possédant par exemple une masse et une charge – et des forces attractives et répulsives de forme plus complexe que la simple répulsion par «contact». À ces points matériels s'ajoutèrent par la suite les champs, comme le champ électrique, répartis dans tout l'espace, servant de médiateurs aux forces entre particules, mais évoluant aussi eux-mêmes selon leurs propres lois. Dès lors, la connaissance exhaustive dont parle Laplace implique aussi celle des champs, et donc une infinité de données, puisqu'il faut connaître l'intensité des champs en chaque point de l'espace26. Il n'en reste pas moins que le modèle «boules de billard» possède toutes les caractéristiques que je vais mentionner du modèle laplacien. Si la subjectivité ne peut trouver sa place au sein d'un modèle «boules de billard», elle ne peut la trouver au sein de la physique laplacienne27. Je me permettrai ainsi souvent de parler comme si celle-ci n'était réellement constituée que de boules de billard, parce que c'est là une image simple qui permet d'en faire ressortir les caractéristiques et les problèmes.

Notons que la physique classique n'est jamais parvenue à proposer une théorie à la fois cohérente et plausible de la réalité; il restait toujours des détails qui clochaient dans les coins28. L'image laplacienne n'en subsiste pas moins comme paradigme de toute physique qui se veut objective, qui croit en une réalité indépendante de l'observateur, puisque la mécanique quantique s'avère incapable de fournir un tel modèle.

La complétude du modèle laplacien

La complétude signifie que tout ce que l'on peut dire du monde est réputé contenu dans la «situation respective des êtres qui [le] composent»; c'est-à-dire, pour reprendre l'image des boules de billard, dans la position et la vitesse de chacune d'entre elles.

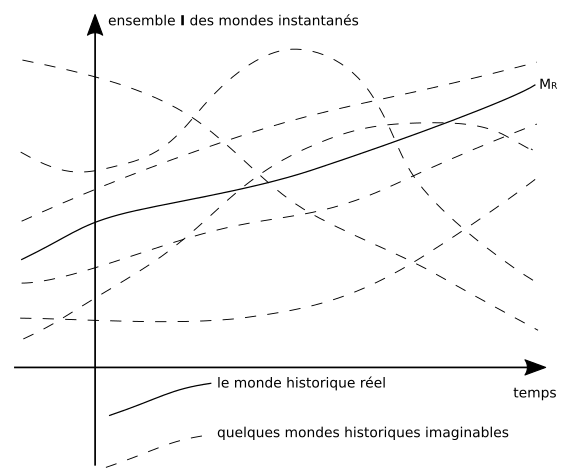

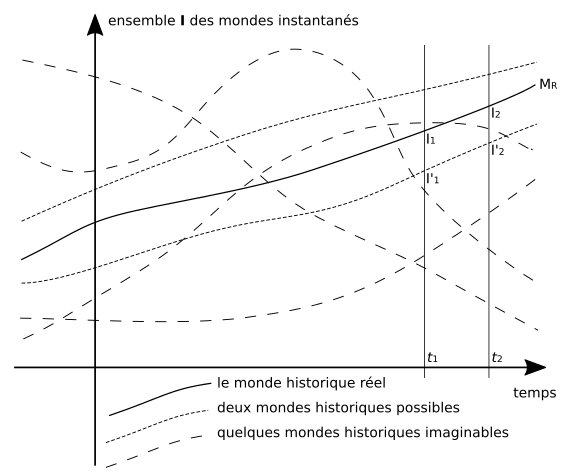

En particulier, le mouvement de nos mains, nos pensées, nos sentiments, tout cela ne serait constitué que de l'entrechoquement «mécanique» de ces boules selon les lois du mouvement. Dire que nous percevons le monde, c'est seulement dire que certaines de ces boules, celles du monde extérieur à notre corps, heurtent d'une certaine manière les boules de notre corps, qui, en raison de leur disposition initiale, vont de proche en proche provoquer certains mouvements et dispositions de certains autres ensembles de boules dans notre cerveau ou ailleurs, mouvements et dispositions qui devront, d'une manière ou d'une autre, constituer la perception. Nos sentiments et émotions seront de la même manière constitués par des dispositions et mouvements de boules quelque part en nous. Lorsque nous agissons en fonction de nos perceptions et sentiments, ce sera parce que ces dispositions et mouvements auront à leur tour, toujours suivant les mêmes lois «mécaniques» du mouvement, provoqué certains mouvements dans d'autres ensembles de boules encore, que nous appelons nos mains, qui écriront nos observations sur une feuille de papier.